Le numérique nous a longtemps été présenté comme immatériel et propre. Mais derrière chaque requête, chaque vidéo et chaque clic, se cache une infrastructure énergivore et gourmande en ressources. Avec l’arrivée de l’intelligence artificielle, cette consommation explose. Peut-elle malgré tout devenir un levier de sobriété, ou sommes-nous prisonniers d’un système qui aggrave ce qu’il prétend réparer ? Cet article explore les enjeux écologiques cachés de l’IA, entre optimisme technologique et réalités matérielles.

- I. Un monde numérique énergivore… mais discret

- II. L’IA comme alliée : un outil au service de la transition

- III. L’IA comme ennemie : une pollution exponentielle et peu encadrée

- IV. Une question politique : qui pilote l’IA, pour quels usages ?

- V. Vers une IA frugale ? Utopie ou piste sérieuse ?

- 📖 Sources

Je me suis posé cette question il y a peu. Moi qui ai toujours utilisé le numérique, qui en ai épousé les codes, les usages, les facilités. Je regarde mes contenus en streaming, souvent en 4K. Je n’écoute plus rien en local depuis des années. Mes morceaux préférés sont stockés quelque part dans un « cloud » invisible, prêts à surgir à la moindre impulsion tactile. Et quand je peux choisir la qualité, je choisis toujours la meilleure. Pourquoi pas ? Je paie pour ça, j’ai la fibre.

J’utilise aussi l’intelligence artificielle. Dans mon cas : pour apprendre, écrire, tester, et surtout, comprendre. Et je ne suis pas le seul. À l’heure où j’écris ces lignes, les générateurs d’images tournent à plein régime : on voit défiler des paysages inspirés de Ghibli, des « starter kits » personnalisés, des mascottes d’univers fictifs par milliers. C’est une vague créative, souvent ludique, parfois creuse. Je pourrais me dire que mon utilisation est plus sérieuse, plus orientée vers la connaissance. Mais ce serait sans doute une illusion de confort. Car dans le fond, je consomme, moi aussi. Beaucoup. Je surfe simplement une autre vague.

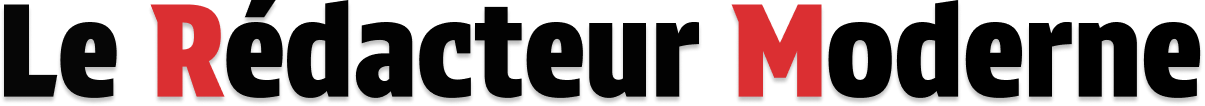

Mais dans ce flot de consommation que je considère encore comme « raisonnable« , je sais désormais que rien n’est neutre. Le numérique pollue. Massivement. Silencieusement. Il a simplement cette capacité étrange à dissimuler son empreinte derrière une interface lisse et une ergonomie fluide. On nous a vendu l’idée que tout cela était immatériel. Ce n’est pas vrai. Derrière chaque requête, chaque image, chaque chanson, il y a des infrastructures gigantesques, des câbles sous-marins, des serveurs affamés et des machines qui tournent jour et nuit.

Et c’est là que naît ma question : L’intelligence artificielle peut-elle cohabiter avec les enjeux écologiques ? Peut-elle faire partie de la solution, ou n’est-elle qu’un nouveau versant du problème ? Le secteur numérique est un terrain où la frugalité pourrait avoir du sens, où l’on pourrait choisir une certaine sobriété technologique… mais en sommes-nous seulement capables ? Et surtout : l’IA peut-elle être sobre ou bien est-elle par essence énergivore ?

I. Un monde numérique énergivore… mais discret

Le problème est là : le numérique semble déconnecté de toute préoccupation énergétique. On oublie que si le contenu n’est pas ici, alors il est ailleurs. Et s’il est ailleurs, centralisé, alors il faut bien que quelque chose ou quelqu’un le stocke, le fasse transiter, le serve à la demande. Depuis les prémices du numérique, nous vivons avec cette illusion d’immatérialité. Le vocabulaire y contribue : cloud, data, flux, streaming… Tout semble léger, invisible, immédiat. Mais derrière ces termes éthérés se cachent des infrastructures physiques massives, qui nécessitent une énergie considérable. Des data centers qui consomment autant qu’une ville. Des câbles sous-marins. Des fermes de serveurs, parfois implantées dans des régions froides pour éviter la surchauffe. Des usines, du cuivre, du lithium. Et des milliards d’équipements utilisateurs connectés en permanence. Et ce n’est pas tout. Ce qu’on oublie souvent, c’est que cette énergie-là ne se limite pas à ce qu’on voit, ni même à ce qu’on utilise à un instant T. Le numérique a cette particularité d’accumuler de l’énergie grise avant, pendant, et après chaque usage :

- Avant, il a fallu extraire les matières premières, produire les équipements, les acheminer, les assembler.

- Pendant, chaque clic, chaque visionnage, chaque synchronisation active une chaîne énergétique continue.

- Après, les données restent stockées, répliquées, sauvegardées. Les appareils deviennent obsolètes, remplacés, puis traités — ou pas.

C’est un cycle. Un flux sans fin, fluide en apparence, mais lourd en coulisses. Même un simple “like”, un rafraîchissement de page ou une recherche vocale enclenche cette chaîne invisible. Faite de câbles, d’électricité, de métaux, de traitements de données. Le clic est léger. L’impact ne l’est pas. Le numérique ne sent rien, ne pèse rien, ne prend pas de place chez nous. Mais il pèse ailleurs. Il chauffe ailleurs. Il impacte ailleurs. Et nous avons simplement appris à ne pas nous en préoccuper.

Au départ, le numérique n’était qu’un outil d’appoint, local, individuel, relativement sobre. On téléchargeait un fichier, on le gardait sur disquette ou clé USB. On envoyait un e-mail ponctuel, on surfait avec lenteur. Mais en l’espace de deux décennies, nous avons basculé dans une consommation continue, massive, distribuée, et surtout invisible à nos yeux. Un mail avec pièce jointe, s’il est stocké sur un serveur pendant des années, a un coût énergétique. Une vidéo YouTube regardée une fois, puis recommandée mille fois, aussi. Scroller une application, rafraîchir une page, liker une photo, envoyer un émoji animé… toutes ces micro-actions s’additionnent dans une spirale énergétique qui nous échappe, parce qu’on ne la voit pas.

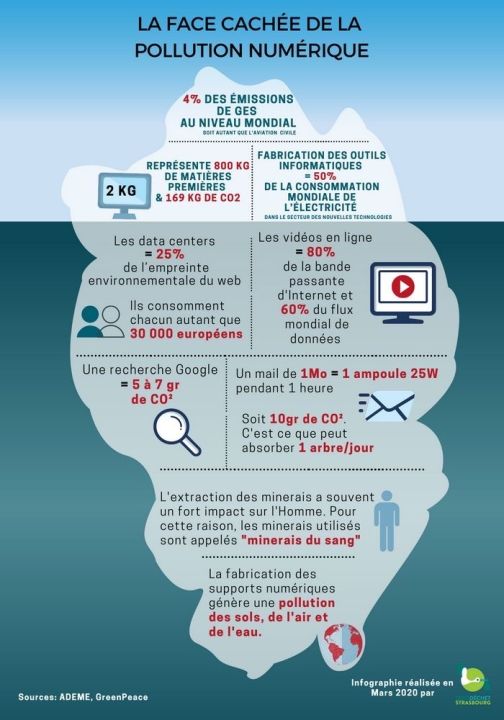

🌍 Quel est l’impact carbone du numérique aujourd’hui ?

Les conséquences du numérique sont donc bien réelles. Voici un état des lieux :

🌍 Chiffres clés : l’impact carbone du numérique

3 à 4,5 % des émissions mondiales de gaz à effet de serre sont dues au numérique (plus que l’aviation civile mondiale).

En France (2022) : 4,4 % de l’empreinte carbone nationale, soit environ 30 millions de tonnes de CO₂ équivalent (comparable au transport routier de marchandises).

Répartition des sources d’émissions :

- 50 % : fabrication et usage des terminaux (ordinateurs, téléviseurs, smartphones, objets connectés)

- 46 % : centres de données (data centers, cloud computing)

- 4 % : réseaux de communication

Exemples concrets :

- 📧 Un mail avec pièce jointe stocké = dizaines de grammes de CO₂

- 💻 Une heure de visio HD = l’équivalent de plusieurs jours d’une ampoule LED

- 🎥 Une vidéo 4K en streaming = des centaines de Mo transférés et stockés

- 📱 Un scroll quotidien sur les réseaux sociaux = milliers de requêtes et synchronisations invisibles

À retenir : le poids écologique du numérique ne vient pas des « barres de signal » ou du Wi-Fi allumé, mais de nos équipements personnels, de nos habitudes de consommation et de la centralisation des contenus.

Les dernières estimations du poids du numérique proviennent de plusieurs organismes comme l’ARCEP (l’expert français des réseaux et des usages numériques, y compris leur consommation énergétique), l’ADEME (l’expert national, toujours français, de référence pour tout ce qui touche à l’environnement et au carbone) et des think tanks tels que The Shift Project. Et cette part pourrait doubler d’ici 2030, si rien ne vient freiner la croissance exponentielle de nos usages. Ce n’est plus une marge résiduelle. Autrement dit : nos équipements personnels, nos habitudes de consommation, et la centralisation massive des contenus sont les principaux responsables. Et comme nous pouvons le voir plus haut, chaque geste compte… Tout cela semble inoffensif, car invisible. Mais nous participons chaque jour à une machinerie énergétique lourde, mondiale et de plus en plus gourmande. Et dans ce contexte déjà saturé, l’intelligence artificielle ne vient pas alléger la facture. Au contraire, elle pousse la logique encore plus loin.

🏭 Le paradoxe de Jevons : quand l’efficacité produit l’excès

L’IA promet de tout rendre plus efficace : nos déplacements, notre consommation d’énergie, notre agriculture, nos bâtiments, nos villes. Elle se présente comme l’outil ultime d’optimisation, capable de traquer les gaspillages, d’anticiper les besoins, d’ajuster les ressources en temps réel. Mais ce récit du progrès par l’intelligence n’est pas nouveau. Et il comporte un piège, ancien, discret, mais toujours actif, et au demeurant, très intéressant : l’effet rebond, aussi appelé paradoxe de Jevons.

🧠 Focus : William Stanley Jevons

Économiste britannique (1835–1882), spécialiste de l’économie politique et de la théorie de l’utilité.

Déjà au XIXe siècle, Jevons observe un phénomène surprenant : plus les machines à vapeur devenaient efficaces, plus la consommation de charbon augmentait. Pourquoi ? Parce que ces machines, devenues moins coûteuses à faire fonctionner, étaient adoptées partout, pour tout. Ce que l’on gagne en efficacité, on le perd — ou on le dépasse — en usage.

Ce principe deviendra ce qu’on appelle aujourd’hui l’effet rebond (ou paradoxe de Jevons). Il s’applique désormais à presque toutes les innovations technologiques, y compris le numérique et l’intelligence artificielle : plus une technologie devient efficace, plus elle est sollicitée, souvent de manière exponentielle.

À noter : Ce paradoxe est crucial pour comprendre pourquoi l’efficacité technologique ne garantit jamais une réduction de la consommation globale sans encadrement ou changement de modèle économique.

Ainsi, ce paradoxe n’a jamais disparu. Il a simplement changé d’échelle, et aujourd’hui, il s’applique à chaque innovation numérique. On compresse mieux les vidéos ? On en regarde plus, en plus haute définition. On automatise une tâche ? On la multiplie à l’infini. On rend les calculs plus performants ? On les lance à tout va, pour prédire des choses que personne n’a demandé à prédire. L’intelligence artificielle, en ce sens, ne fait pas exception. Elle pourrait même devenir le cœur d’un effet rebond démultiplié, un moteur d’usage continu dans un monde où tout est mesurable, prévisible, monétisable.

⛏️La géographie cachée du numérique

Il faut aussi le dire clairement : cette machinerie numérique que nous alimentons chaque jour ne repose pas uniquement sur des infrastructures techniques — elle repose aussi sur une géographie inégale des impacts. Car si nous profitons ici de services fluides, rapides, disponibles en un clic, c’est parce qu’une grande partie des coûts écologiques — et humains — a été déplacée ailleurs. L’extraction du cobalt nécessaire à nos batteries se fait principalement en République démocratique du Congo, souvent dans des conditions environnementales et sociales catastrophiques. Le lithium, au cœur des appareils et de l’IA embarquée, vient des hauts plateaux d’Amérique du Sud, où son extraction menace les réserves d’eau des populations locales. Les puces électroniques les plus avancées sont produites en Asie de l’Est, notamment à Taïwan et en Corée du Sud, par des usines ultra-spécialisées dont les besoins énergétiques et hydriques explosent. Quant à nos données, elles voyagent jusqu’à des data centers géants implantés en Europe du Nord, au Canada ou en Islande, choisis pour leur climat froid, mais pas toujours pour leur énergie renouvelable. Bref, nous avons dématérialisé l’usage, mais pas l’impact. Et cette déconnexion géographique renforce l’illusion de légèreté : on ne voit pas ce que l’on consomme, parce que les dégâts sont ailleurs.

L’intelligence artificielle ne vient pas bouleverser ce modèle. Au contraire, elle s’y inscrit pleinement… mais va encore plus loin : en exigeant toujours plus de données, de puissance de calcul, d’équipements performants, et donc toujours plus d’extraction, de production, de stockage, d’énergie. Elle pousse à l’extrême cette logique d’accélération dématérialisée, dont les fondations matérielles sont bien réelles — mais toujours localisées ailleurs.

II. L’IA comme alliée : un outil au service de la transition

Rappelons-nous que cet état des lieux date d’avril 2025, tout cela aura fortement changé par la suite… mais, actuellement, dans les discours des plus optimistes — ceux qui prennent en considération l’urgence climatique — l’intelligence artificielle se distingue des autres usages numériques par une promesse spécifique : celle de l’optimisation des flux. Énergie, transport, agriculture… partout où il y a du gaspillage, de l’inefficience, des données à exploiter, l’IA est présentée comme un levier capable de faire mieux avec moins.

⚡ 1. Dans le domaine de l’énergie

L’IA pourrait ainsi prédire les pics de consommation énergétiques, ajuster la distribution, et intégrer plus efficacement les énergies renouvelables intermittentes (comme le solaire ou l’éolien). Elle peut aussi optimiser la consommation des bâtiments intelligents, ou proposer des plans d’économie personnalisés aux entreprises. Exemple : des modèles d’IA sont déjà utilisés pour optimiser la charge des batteries domestiques selon les pics de production solaire.

🚛 2. Dans le domaine du transport

L’IA est aussi au cœur des véhicules autonomes, souvent présentés comme plus sobres… même si cela reste discutable à grande échelle. L’IA permettrait de fluidifier la circulation, optimiser les itinéraires, réduire les embouteillages (et donc les émissions). Dans la logistique, elle pourrait rationaliser les livraisons, réduire les trajets à vide, ou optimiser la gestion des flottes.

🌾 3. Et dans le domaine de l’agriculture

Grâce à l’analyse d’image, de données météo, de capteurs au sol, l’IA peut aider à cibler les besoins en eau, réduire les intrants (pesticides, engrais), ou prédire les rendements. On parle même d’agriculture de précision, avec des drones ou robots pilotés par IA, capables de traiter plante par plante.

En théorie, chaque seconde gagnée, chaque ressource économisée, chaque kilowatt évité est une victoire. Mais dans les faits ? Ces victoires se réinjectent immédiatement dans le système. On gagne 5 secondes ici ? On les investit pour produire 5 secondes de plus ailleurs. On libère des ressources ? On s’empresse de les utiliser autrement. L’optimisation ne mène pas à la sobriété. Elle mène à une accélération mieux huilée. C’est ici que revient l’effet rebond. L’IA n’annule pas le déséquilibre. Elle le rationalise. Elle rend acceptable, performant, même écologique en apparence, un modèle qui reste fondé sur l’extension continue des usages. Et c’est peut-être là le plus grand malentendu contemporain : croire que la technologie va réparer ce qu’une autre technologie a permis de dérégler. Sans jamais se demander : fallait-il vraiment le faire ?

L’IA comme outil d’aide à la décision environnementale

Au-delà de la promesse d’optimisation des flux, l’IA est aussi mobilisée pour éclairer les choix politiques et scientifiques face à la crise écologique. Son rôle ici est plus discret, mais potentiellement plus structurant : il s’agit de modéliser, anticiper, simuler, pour mieux comprendre l’impact de certaines actions — ou inactions. Exemples d’usage :

🏛️ Aide à la prise de décision publique

Certains outils d’intelligence artificielle sont désormais pensés pour accompagner les décisions publiques, en croisant données scientifiques, économiques et sociales, puis en simulant l’impact de telle ou telle politique. Une forme de laboratoire prospectif, piloté par algorithme.

Des chercheurs, par exemple, ont utilisé des modèles de langage de grande taille (LLM) pour simuler les effets sociaux perçus d’une nouvelle loi. Ils ont testé l’article 50 du projet de règlement européen sur l’IA — pas pour dire s’il est bon ou mauvais, mais pour voir comment il serait reçu. Une autre manière de faire de la politique : anticiper l’opinion, pas seulement l’impact. En France, le gouvernement prévoit aussi l’intégration de l’IA dans les services publics. Chaque ministère devra établir une feuille de route d’ici 2025. Objectif affiché : simplifier, automatiser, optimiser. C’est le versant pragmatique, technocratique, celui de l’efficience. Et dans certaines collectivités, l’IA est déjà utilisée pour détecter des signaux faibles dans les données publiques : mobilité, énergie, santé… Quand une anomalie surgit, le système peut suggérer une réponse, ou même déclencher une action automatique. Une promesse de réactivité. Mais aussi, parfois, un risque de court-circuiter le jugement humain.

🌍 Modèles climatiques complexes

L’intelligence artificielle s’invite aussi dans un autre champ : la modélisation climatique. Elle permet de croiser des variables multiples — températures, précipitations, usage des sols, mouvements atmosphériques — et d’accélérer les simulations là où les modèles traditionnels prennent du temps, beaucoup de temps.

Au CNRS, par exemple, des chercheurs ont mis au point un modèle basé sur le deep learning pour mieux prévoir les canicules. En combinant données passées et projections, leur IA identifie plus tôt les vagues de chaleur extrême. Une avancée potentiellement précieuse — à condition que les décideurs veuillent l’entendre. Au Québec, l’initiative ClimateSet propose un gigantesque jeu de données climatique, issu de 36 modèles internationaux, destiné à nourrir des prédictions plus localisées, plus fines, plus longues. Pas pour générer des logos ou des avatars, mais pour produire des trajectoires sur un siècle. Une autre forme d’anticipation. Et puis il y a les projets ACE ou ClimaX, qui explorent une voie hybride : des modèles atmosphériques globaux “appris”, capables de simuler le climat mondial aussi bien, voire plus rapidement, que les approches classiques. L’idée ? Adapter l’outil à la complexité du réel, sans tout simplifier. Faire du climat une question de calcul — sans que cela devienne une illusion de maîtrise.

Ces outils ne remplacent pas les climatologues ni les décideurs, mais ils permettent de rendre visible l’invisible, de faire émerger des tendances, des risques, des points de bascule. Encore faut-il que ces signaux soient pris en compte. Et là encore, ce n’est pas l’IA qui décide.

💧 Gestion des ressources naturelles : IA et biodiversité

L’intelligence artificielle commence aussi à se frayer un chemin dans la gestion des ressources naturelles, de l’eau à la biodiversité. On lui confie des missions autrefois lentes, manuelles, humaines — cartographier, détecter, anticiper — avec la promesse d’une efficacité nouvelle. Mais comme toujours, tout dépendra de l’intention d’usage : préserver… ou exploiter davantage.

🌿 Pour la biodiversité : observer sans déranger

Certaines IA sont désormais capables d’identifier des espèces végétales simplement à partir d’une photo. C’est le cas de Pl@ntNet, une appli participative qui contribue à l’inventaire collectif de la flore, en s’appuyant sur l’analyse automatique d’image. Dans les forêts françaises, le projet Sonosylva va plus loin encore : il écoute la biodiversité. Des micros captent les sons, et l’IA identifie les espèces à partir de leurs signatures acoustiques. Plus besoin de perturber l’environnement pour le surveiller. Côté mer, l’IA permet aussi de suivre les migrations et comportements d’espèces marines, en croisant températures de l’eau, pollution, et signaux biologiques.

💧 Pour l’eau : économiser au bon endroit, au bon moment

À Singapour, des systèmes intelligents croisent météo, données historiques et croissance démographique pour prévoir la demande en eau. Résultat : une gestion plus souple, plus anticipative. Des capteurs couplés à l’IA permettent également de repérer les fuites en temps réel dans les réseaux — une technologie de plus en plus déployée pour éviter des pertes massives. Et en agriculture, certains outils ajustent l’irrigation au plus juste, en fonction de l’humidité du sol, du type de culture, ou des prévisions météo. Moins de gaspillage, moins d’arrosage “à l’aveugle”. On le voit ici encore : les outils sont là, prometteurs, parfois déjà opérationnels. Mais leur impact réel dépendra de notre volonté à les utiliser dans une logique de sobriété, pas simplement d’optimisation. Observer plus finement pour préserver, pas pour intensifier.

⚖️ L’automatisation vertueuse ?

À la lecture de tous ces cas d’usage — agriculture de précision, modélisation climatique, prévision des besoins en eau, conservation de la biodiversité… — l’IA semble pouvoir tout améliorer. Plus vite, plus finement, plus intelligemment. Et, dans une certaine mesure, c’est vrai. Ces outils ont un potentiel réel. Ceux qui les conçoivent — chercheurs, ingénieurs, innovateurs — sont souvent sincèrement convaincus de leur utilité écologique. Ils veulent rendre visible l’invisible, traquer le gaspillage, éviter l’aveuglement des systèmes lourds. Une forme d’automatisation vertueuse, en apparence.

Mais il y a un écart. Parce que ces outils ne tombent pas du ciel. Ils ne sont pas neutres.

Ils sont produits, financés, hébergés et déployés dans un monde économique structuré autour d’un impératif : la rentabilité. Et dans ce monde-là, ce qui compte n’est pas uniquement ce qu’un outil permet de faire, mais ce qu’il permet de vendre. Alors oui, l’IA peut aider à anticiper les sécheresses. Mais qui contrôle l’outil ? Et dans quel but ? Est-ce pour répartir équitablement la ressource ou pour optimiser le rendement d’un monopole agricole ? Est-ce pour protéger un écosystème fragile ou pour le surveiller avant de mieux l’exploiter ? On touche ici un point de bascule moral et économique : Ce n’est pas la puissance de l’IA qui compte. C’est le cadre dans lequel elle opère. Et tant que ce cadre sera régi par la logique privée, concurrentielle, extractive, même les meilleures intentions risquent de se diluer. L’IA écologique n’est pas impossible. Mais elle ne pourra pas l’être dans un système qui valorise la croissance infinie, et qui n’accorde de valeur qu’à ce qui se monétise. Alors on applaudit les potentialités. Mais dans les coulisses, une autre dynamique est à l’œuvre. Plus discrète. Plus brutale. Et si on changeait de perspective, juste un instant ? Et si l’IA, loin de sauver la planète, était en train d’aggraver ce qui la menace ? Car cette promesse d’utilité cache une réalité bien plus lourde, matérielle, persistante. Car avant d’optimiser, il faut entraîner. Et entraîner, ça coûte. Beaucoup.

III. L’IA comme ennemie : une pollution exponentielle et peu encadrée

On parle souvent d’entraînement de l’IA. Le mot est bien choisi : il évoque un processus long, méthodique, presque noble. On imagine une entité appliquée, comme un étudiant plongé dans une bibliothèque, feuilletant des millions d’ouvrages, assimilant patiemment le savoir humain. Ou, à l’inverse, un corps mécanique qui sue à grosses gouttes, enchaînant des exercices mentaux comme un athlète du numérique. Mais cette image est trompeuse. L’IA ne lit pas. Elle calcule. Et pour apprendre, elle doit brasser des volumes colossaux de données : des milliards de phrases, d’images, de corrélations, traitées par des algorithmes capables de repérer des motifs dans l’apparent chaos. Cela exige une puissance de calcul démesurée, mobilisée pendant des jours, parfois des semaines, sur des fermes de serveurs qui tournent en continu, alimentées par des ressources énergétiques bien concrètes.

À ce stade, on parle de ce qu’on appelle des LLM, ou Large Language Models : des modèles de traitement du langage naturel conçus pour générer du texte, répondre à des questions ou résumer de l’information. Le plus connu est GPT, développé par OpenAI, mais il en existe d’autres : Claude, Gemini, LLaMA, Mistral… Tous sont ce qu’on appelle des modèles lourds : ils mobilisent des milliards de paramètres, nécessitent des pétabytes de données pour être entraînés, et engloutissent des millions d’heures de calcul GPU. Entraîner un seul modèle de ce type — comme ceux derrière les IA génératives actuelles — peut nécessiter l’équivalent de centaines de tonnes de CO₂, soit plus que ce qu’un individu moyen émet en un an. Et cela ne concerne que l’entraînement initial. Car ensuite viennent les mises à jour, les ajustements continus, et surtout les déploiements massifs, avec des milliards de requêtes individuelles chaque jour. Autrement dit : ce n’est pas une IA qui s’entraîne une fois pour toutes, mais un système perpétuellement actif, auto-alimenté par nos usages et nos attentes.

🤖 Focus : Les principaux termes de l’IA générative

LLM (Large Language Model) : Catégorie générale qui regroupe les modèles de traitement du langage naturel. Ces IA sont entraînées sur des milliards de textes et données pour comprendre et générer du langage humain.

Les exemples les plus connus de LLM incluent :

GPT : « Generative Pre-trained Transformer ». Créé par OpenAI (GPT-3, GPT-4…), utilisé pour générer du texte et répondre à des questions.

Claude : Développé par Anthropic, axé sur la sécurité et la cohérence des réponses.

Gemini : Modèle de Google DeepMind (successeur de Bard), capable de traiter du texte, des images et d’autres types de données.

LLaMA : « Large Language Model Meta AI », série de modèles développés par Meta (Facebook), avec une orientation open source.

Mistral : Modèle européen open source, reconnu pour son efficacité et sa légèreté relative.

À noter : Tous ces modèles sont dits « lourds » : ils utilisent des milliards de paramètres et nécessitent une puissance informatique très élevée pour l’entraînement et l’usage.

Un paramètre est une valeur ajustable que le modèle apprend à modifier pour repérer des relations entre les mots ou les images et affiner ses réponses.

🔁 Servitude à la croissance : quand l’IA alimente le système qu’elle prétend corriger

Dans un monde en quête de sobriété, on pourrait s’attendre à ce que les technologies dites “intelligentes” nous aident à ralentir. À mieux cibler nos usages, à filtrer l’essentiel, à nous libérer du superflu. Mais la réalité est plus cynique : l’intelligence artificielle ne nous éloigne pas du modèle productiviste. Elle s’y soumet. Elle le sert. Elle l’accélère. Parce qu’elle est conçue dans un écosystème régi par la compétition, la monétisation, la visibilité à tout prix. Parce que ses usages dominants — publicitaires, marchands, ludiques — ne sont pas orientés vers la préservation, mais vers la captation. Captation de l’attention, des données, des désirs. Et captation du temps, qu’on croyait gagner mais qu’on perd autrement.

L’IA est donc au service d’une économie de la saturation : plus d’interactions, plus de recommandations, plus de contenu, plus de vitesse. Elle automatise la production de mails, de visuels, de vidéos, de musiques, de profils… jusqu’à rendre chaque utilisateur potentiellement générateur d’un flux perpétuel. Et dans ce flux, chaque seconde d’optimisation devient une nouvelle unité à monétiser. Alors on parle d’assistance, mais c’est de la dépendance. On parle de gain de productivité, mais c’est une fuite en avant. L’IA n’est pas, en l’état, un outil d’émancipation. C’est un moteur de croissance intégré, calibré pour servir un système qui ne connaît qu’un seul langage : celui de la performance. Et tant qu’elle sera développée dans ce cadre, elle restera — malgré ses vertus — un agent d’aggravation écologique. Pas parce qu’elle est mauvaise. Mais parce qu’elle est soumise à une logique qui, elle, l’est profondément.

IV. Une question politique : qui pilote l’IA, pour quels usages ?

L’IA ne pense pas : elle applique des objectifs fixés en amont

Il est important de dissiper une idée reçue : malgré son nom, l’intelligence artificielle ne « pense » pas au sens humain du terme. Elle ne possède ni intentions, ni conscience, ni jugement moral. Elle exécute des instructions et applique des objectifs qui lui sont fixés en amont, par des concepteurs humains. Ces objectifs peuvent être simples (reconnaître un visage, classer des images) ou complexes (résumer un texte, simuler un dialogue), mais ils restent des buts définis par ceux qui créent, entraînent et déploient le modèle. Ces décideurs sont, dans l’immense majorité des cas, des entreprises privées ou des consortiums financés par des capitaux privés. Leur priorité n’est pas l’intérêt général, mais des objectifs économiques : rentabilité, captation de parts de marché, optimisation des services payants ou collecte de données. Avant d’examiner les biais et les priorités qui influencent l’IA, il est utile de rappeler quels types d’objectifs sont généralement fixés à ces systèmes, au-delà des cas particuliers :

🎯 Focus : Quels objectifs fixe-t-on aux IA ?

Les IA appliquent des objectifs définis par leurs concepteurs, qui varient selon les usages mais suivent des grandes catégories communes :

- Optimisation : Améliorer la vitesse, la précision ou le coût de traitement d’une tâche (ex. : traduction, recherche d’information, production de contenu).

- Prédiction : Anticiper des résultats ou comportements futurs à partir de données passées (ex. : recommandations de produits, prévisions climatiques, détection de fraudes).

- Automatisation : Réaliser de manière autonome des tâches répétitives ou complexes (ex. : modération de contenu, véhicules autonomes, automatisation administrative).

- Personnalisation : Adapter les réponses ou services à chaque utilisateur pour maximiser la pertinence ou l’engagement (ex. : publicité ciblée, algorithmes de réseaux sociaux).

- Rentabilité commerciale : Maximiser l’efficacité économique, souvent par la réduction des coûts ou l’augmentation de l’engagement/dépendance des utilisateurs.

- Alignement éthique (garde-fous) : Restreindre certains comportements indésirables (discrimination, propos haineux, désinformation), même si ces filtres sont toujours perfectibles.

À noter : Même lorsque des objectifs « vertueux » (écologie, éthique, accessibilité) sont intégrés, ils restent secondaires face aux impératifs d’efficacité et de rentabilité qui dominent la conception de la majorité des IA actuelles.

Les citoyens et la société civile ont très peu de pouvoir sur ces choix fondamentaux. Ils peuvent donner leur avis a posteriori, via la critique publique ou la régulation, mais ils n’ont pratiquement aucune influence sur la définition des objectifs initiaux. Même lorsque des cadres éthiques ou des principes de gouvernance sont annoncés, ils émanent le plus souvent d’initiatives internes aux entreprises elles-mêmes ou de négociations entre acteurs institutionnels et privés. Pour tenter de limiter les risques d’abus, un domaine de recherche appelé « l’alignement » (alignment) s’est développé. Il s’agit de concevoir des garde-fous destinés à contrôler le comportement des IA : respect de normes morales, éthiques, et légales ; filtrage des réponses ; modération automatique ; et ajustements continus en fonction des usages et des signalements. Cet alignement, cependant, reste imparfait. Il reflète les priorités et les valeurs de ses concepteurs, qui peuvent varier d’une entreprise à l’autre et d’un contexte culturel à l’autre. Et surtout, il n’échappe pas à une contradiction de fond : tant que les objectifs fixés à l’IA seront déterminés par des logiques commerciales et productivistes, les garde-fous éthiques risquent d’être des correctifs partiels, incapables de changer le cadre global dans lequel l’IA opère.

Biais et priorités : une neutralité impossible et la nécessité d’une gouvernance globale

Même si les concepteurs d’IA poursuivent souvent un idéal de neutralité — que ce soit dans le traitement de l’information, la modération des réponses ou la représentation des faits — cette neutralité absolue reste inatteignable. Les biais sont inévitables, car ils reflètent non seulement les limites des algorithmes eux-mêmes, mais surtout celles des données sur lesquelles ils sont entraînés. Or, ces données sont produites par des humains, dans des contextes sociaux, culturels, économiques et historiques qui véhiculent leurs propres préjugés, discriminations ou angles morts. Plus encore, le choix des objectifs (voir encart précédent) et des garde-fous éthiques est lui-même un acte biaisé : décider ce qui doit être permis ou interdit, encouragé ou découragé, est toujours un choix politique et moral.

Face à ces biais structurels, il est dangereux de laisser les entreprises privées — même bien intentionnées — décider seules des priorités éthiques et sociales. Les intérêts commerciaux et la logique concurrentielle les poussent à privilégier la rapidité de développement, l’efficacité économique et l’expansion des usages, souvent au détriment de réflexions plus profondes sur l’équité, l’environnement ou la diversité culturelle. Il devient donc indispensable d’imaginer une forme de gouvernance globale. À l’image des chartes internationales sur les droits humains, il serait pertinent de définir un cadre éthique commun applicable à toutes les IA, qu’elles soient développées par des acteurs privés ou publics, et qu’elles soient open source ou propriétaires. Cette gouvernance devrait inclure non seulement des experts techniques et des entreprises, mais aussi des représentants des sociétés civiles, des chercheurs en sciences humaines, des juristes et des acteurs de la transition écologique. Voici, par curiosité, quelques exemples concrets où l’absence de régulation ou de vigilance face aux biais a conduit à des dérives bien réelles :

⚠️ Exemples de biais et dérives des IA

- Microsoft Tay (2016) : chatbot devenu raciste et sexiste après quelques heures sur Twitter, en apprenant sans filtre des utilisateurs.

- Amazon Recrutement (2018) : algorithme de sélection de CV qui discriminait les femmes, car il avait été formé sur des données historiques biaisées.

- Reconnaissance faciale : plusieurs systèmes ont montré des taux d’erreur beaucoup plus élevés pour les personnes racisées, entraînant des arrestations injustifiées.

- IA génératives (2023-2024) : reproduction de biais raciaux et sexistes dans les images ou les textes générés, notamment des stéréotypes sur les genres et les professions.

À noter : Ces exemples illustrent pourquoi l’idée de neutralité algorithmique est une illusion. Sans garde-fous solides et sans supervision humaine, les biais existants sont non seulement reproduits, mais parfois amplifiés.

V. Vers une IA frugale ? Utopie ou piste sérieuse ?

Comme pour le reste de nos usages, nous ne sortirons pas de cette impasse uniquement par des gestes individuels. Refuser la 4K (ouille), garder son smartphone 6 ans, ne pas demander à une IA de réécrire ses mails… tout cela a un sens. Mais c’est bien peu de chose face à une machine économique et culturelle qui pousse dans l’autre sens. Il ne suffit pas de “mieux utiliser” l’IA. Il faut imaginer autrement son développement. Des solutions de frugalité existent, et il s’agit souvent de « il suffirait de…« , mais comme pour le reste du combat écologique versus l’économie libérale et capitaliste, il y aura toujours un renvoi de balles entre les industriels et les particuliers… voici quelques pistes :

🔋 L’IA low-tech : moins de puissance, plus de bon sens

Tout ne nécessite pas un modèle géant. On peut développer : des IA locales, embarquées directement dans l’appareil, sans appel au cloud (comme certaines IA de smartphone en mode avion), des modèles plus petits, spécialisés, qui consomment beaucoup moins de ressources tout en rendant des services ciblés, des architectures fondées sur le edge computing (ou « informatique en périphérie« ) où les données sont traitées au plus près de leur source (moins de transfert, moins de cloud, plus de contrôle local). Ce sont des scenarios concrets, déjà en cours dans certains projets open source ou industriels… mais loin du modèle dominant, qui valorise la centralisation, la performance maximale, la dépendance au réseau.

🛰️ Focus : Le Edge Computing (informatique en périphérie)

Définition : Le edge computing consiste à traiter les données au plus près de leur source (sur le terminal lui-même ou sur un serveur local), plutôt que de les envoyer vers des centres de données distants (cloud).

Avantages écologiques : Moins de transferts de données ➔ réduction de la consommation énergétique liée au réseau et aux data centers. Les appareils peuvent fonctionner même sans connexion constante.

Exemples : Certaines IA de smartphones qui fonctionnent en mode avion, systèmes domotiques locaux, ou encore des véhicules autonomes traitant les données sur place.

À noter : Le edge computing favorise la sobriété numérique et donne plus de contrôle local à l’utilisateur. Il s’oppose à la logique dominante du cloud centralisé, gourmand en énergie et en ressources.

🧭 L’alternance nécessaire : innover, mais aussi renoncer

La véritable sobriété numérique ne viendra pas seulement d’une meilleure technologie, mais d’un autre rapport à la technologie. Un rapport dans lequel on ne chercherait pas toujours à faire plus vite, plus fluide, plus impressionnant. Un rapport qui inclurait le renoncement comme un choix conscient, pas comme une régression. Tout ne mérite pas d’être automatisé. Tout ne mérite pas d’être généré (ou ce qui doit être généré devrait idéalement être précédé d’une demande/prompt complète et précise pour éviter les nouvelles itérations inutiles). Tout ne mérite pas d’être prévu. Et si la vraie prouesse n’était pas d’en faire plus avec moins… … mais d’apprendre à faire moins — volontairement ?

🤔 La tech peut-elle aider à ralentir ?

C’est peut-être la question la plus subversive à poser aujourd’hui. Parce que tant que la technologie sera conçue comme une promesse d’accélération permanente, elle ne pourra pas être écologique. Mais si elle devient un outil de ralentissement, d’attention, de recentrage, alors peut-être pourra-t-elle contribuer à un autre récit. Un récit qui irait à contrecourant du modèle économique dominant.

Mais, encore une fois, comme toute sensibilisation du genre, on mise sur le pouvoir de la technologie. On lui délègue ce pouvoir, comme si elle était l’agent principal du changement — pour pouvoir, nous, revenir tranquillement à notre quotidien confortable et ultraconnecté. Et c’est là que le piège se referme : On critique l’accélération… mais on attend que la solution vienne du moteur lui-même.

Alors non, je n’ai peut-être pas de solution. Mais prendre conscience de notre impact, en offrant une place si centrale au numérique, c’est déjà un pas de côté. Un effort de regard. Et c’est toujours mieux que détourner les yeux — notre grande spécialité, sur tant de sujets. Mais soyons honnêtes : à l’heure actuelle, comme beaucoup d’entre nous, je ne risque pas encore de freiner mon usage, même si je fais quelques actions symboliques. Et c’est peut-être ça, le plus effrayant.

Sources

- Le Monde Informatique – 5 avril 2024

L’intelligence artificielle dans la fonction publique : priorité 2025 - Université de Pennsylvanie – 2023

Simulating Public Policy Impacts Using LLMs (arXiv)

(étude sur la simulation des effets sociaux perçus d’une loi via GPT-4) - Acteurs Publics – 2023

Intelligence artificielle et services publics : vers une nouvelle gouvernance ? - France Stratégie & Etalab (travaux généraux sur IA et politique publique)

https://www.strategie.gouv.fr | https://www.etalab.gouv.fr - CNRS – Une meilleure prédiction des canicules grâce à l’IA

cnrs.fr - Mila – L’IA pour prédire les variations climatiques sur un siècle

mila.quebec - ArXiv – ACE : un modèle atmosphérique global appris

arxiv.org/abs/2310.02074 - ArXiv – ClimaX : un modèle fondation pour le climat

arxiv.org/abs/2301.10343 - Pl@ntNet – Application de reconnaissance de plantes par IA

Wikipedia – Pl@ntNet - IA pour la biodiversité marine

Pêche.com – L’intelligence artificielle pour protéger la biodiversité marine - Sonosylva – Surveillance acoustique des forêts en France

Le Monde – Écouter la forêt pour mieux comprendre la biodiversité - Prévision intelligente de la demande en eau – Singapour

TABS – AI’s Role in Improving Water Resource Management - Détection des fuites via IA et capteurs

Medium – Smart Water Management Systems Using AI - Optimisation de l’irrigation agricole

White & Case – AI in Water Management: Balancing Innovation and Consumption

Charte de transparence IA

🧠 Idée : 100 % humaine

📁 Structure : Je prends désormais l’habitude de faire faire un plan par l’IA suite à un échange approfondi.

✍️ Rédaction : Dans ce sujet, bien que très passionnant, je me suis laissé emporté par la maîtrise du sujet de l’IA… j’ai donc beaucoup réorienté mais j’ai été plus spectateur que je l’aurais voulu. On assiste dans tous les cas à une réalité qu’on ne peut ignorer… mais pour cela il va falloir que je balaye sérieusement devant ma porte avant toute chose.

🎨 Illustrations : Générées en grande partie par IA (j’ai essayé de parfaire ma composition de prompt).

Intervention globale de l’IA estimée : 80 %

Laisser un commentaire